Pressemeddelelse fra Alexandra Instituttet

Eller knap så højtflyvende, så giver denne blogpost en introduktion til begreberne “fairness” og “bias” i maskinlæring. For den danske oversættelses skyld vil vi benytte ordet ‘skævhed’ i stedet for ‘bias’. Vi kan tænke på det som en form for uhensigtsmæssighed, som er skadelig i form af uretfærdige fordomme eller behandlinger af enkelte personer eller grupper. En af frontfigurerne på plakaten er Kate Crawford, som holdt en om emnet på NIPS 2017 (konference om Neural Information Processing Systems), og i sin definition af begrebet skelner hun mellem uhensigtsmæssigheder i form af allokering af ressourcer og muligheder, og uhensigtsmæssighed i form af repræsentationer, som knytter sig til identitet og hvordan folk opfattes.

Denne skelnen vil vi kæmpe lidt videre med, hvorefter vi kigger på, hvordan skævheder opstår, definitioner på fairness, metoder til at undgå det, og i tillæg, da alle superhelte jo kræver træning, vil vi hente superhero dataset fra at øve os på.

Nogle er mennesker, andre er kryptonians…

… og atter andre tilhører en helt tredje gruppe. Maskinlæring kan bruges til beslutningsstøtte til fordelinger af ressourcer og muligheder, og her kan skævheder opstå, hvis personer eller bestemte grupper bliver favoriseret eller diskrimineret. Eksempler på uønskede skævheder er, hvis kreditvurderinger afhænger af race, eller hvis anbefalinger af jobansøgninger afhænger af køn. I dette setup arbejdes der med såkaldte “beskyttede attributter”, som angiver tilhørsforhold til en gruppe, som man ønsker at beskytte, og traditionelt er der her kig på køn, race, nationalitet eller etnicitet. Målet med fair maskinlæring er så at sikre ‘retfærdigheden’ af modellerne, men hvordan dette overhovedet kan formaliseres, vil vi løfte masken for senere.

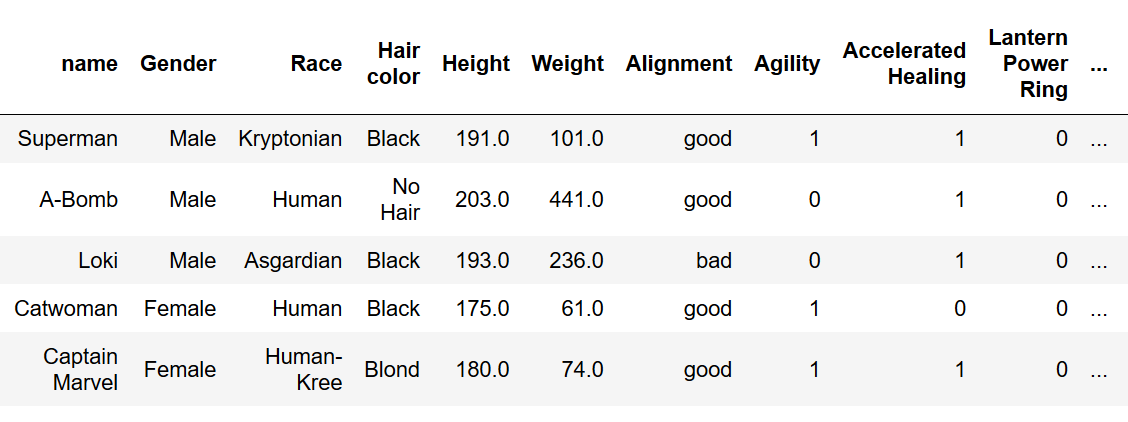

I vores superhelte-datasæt fra Kaggle er der angivet navne på en række superhelte, deres egenskaber, en række personkarakteristikker såsom køn og race, samt hvorvidt superheltene er gode elle onde. I denne blogpost vil vi gerne prædiktere, om en superhelt er god eller ond, men det skal være på en måde, som sikrer ligebehandling af kønnene. Men igen, hvad vil det sige, eller spørgsmålet er nok snarere, hvad kan det sige?

Fem eksempler fra datasættet, dog ikke alle superkæfter er vist. Et 1-tal betyder at helten besidder kraften.

Det er dragten…

… som giver superhelten identitet. Den anden form for skævhed, som defineret af Kate Crawford, går på, hvordan vi repræsenter folk. Hvordan folk fremstilles, kan have en problematisk indflydelse på, hvordan vi i sidste ende opfatter bestemte grupper. Ofte fremhævede eksempler i debatten, til at vække harme, var, da Google Photo taggede en afroamerikansk kvinde som gorilla, (), eller at der er kønsstereotyper i måden, ord repræsenteres på i Natural Language Proessing (Se mit om word embeddings), eller tilfælde hvor ansigtsgenkendelse virker dårligere på mørk hud end lys hud. Et andet eksempler er fra 2015, hvor en google-søgning på CEO, resulterede hovedsageligt i billeder af hvide mænd i slips, og hvor det første billede af en kvinde, 10 rækker nede, var en Barbiedukke udklædt som CEO (). Superhelte-branchen er måske ikke just selv det gode eksempel på en fair kønsfordeling og repræsentation – så hvorfor, og hvornår, handler de her ting overhovedet om maskinlæring?

Hvordan kommer vi i Justice League…

… med vores maskinlæringsmodeller? Det grundlæggende problem ved eksemplerne ovenover er teknisk set ikke, at modellerne indimellem fejler, som ved klassificeringer af en kvinde som en gorilla, men at systemerne her reproducerer og automatiserer en skævhed og diskrimination, som allerede er til stede i samfundet eller som er historisk, som fx racisme mod afroamerikanerne. Det er derfor, at eksemplet med den afroamerikanske kvinde bliver så slående. I det andet eksempel med søgningen på CEO problematiserer Kate Crawford, hvad et fair resultat i givet fald ville være; skal søgningen vise den aktuelle fordeling af køn og etnicitet på folk, der besidder en CEO-post, eller skal den vise den fordeling, som folk synes er fair? Hvordan mennesker bliver klassificeret og repræsenteret, er ikke blot et maskinlærings-problem, men et samfundsproblem, og svaret på hvad en fair model er, går derfor også udover det tekniske i at fjerne skævheder fra modellerne til også at være et etisk, kulturelt og politisk spørgsmål. Og svaret på, hvad der er fair, er i sig selv tidsligt og kulturelt bestemt – og vil ændre sig igen over tid.

Her føler man sig måske fanget i spindelvævet. Men selvom der ikke er noget entydigt svar på, hvad en fair model er, er det vigtig at opbygge viden og forståelse for, hvorledes uhensigtsmæssigheder kan være til stede, hvorfor de opstår, og hvordan de kan håndteres for at sikre, at maskinlæring forbliver et anvendeligt værktøj. Disse ting vil vi introduktionsvis tage hul på i de næste paragrafer.

Det er data, der er skurken!

Ofte, når vi prøver at finde årsager til skævheder i maskinlæringsmodeller, skal vi kigge i træningsdata. Disse skævheder kan være forskyldt af kulturelle eller historiske grunde, men det kan også være mere på grund af uvidenhed eller fejl. Det kan da nævnes, at skævheder også kan opstå fra valg af algoritme, da man kan forstille sig, at repræsentation for én gruppe er sværere at lære for en type algoritme end for en anden. Nogle af de potentiale årsager til, hvorfor skævheder opstår i data, er listet herunder, men du kan også læse mere om det i fx denne .

- Skæv dataopsamling. Hvis der fx har været en skævhed til at starte med, kan det blive forstærket over tid. Et eksempel kunne være: Det altid-ét-skridt-bagefter politi i superheltefilm har kun optegnelser over de forbrydelser, som de faktisk udforsker, og hvis de historisk set har fokuseret mest på et område (eller en race), vil det resultere i, at billedet af forbrydelser i andre områder er mindre kendte.

- Manglende værdier. Data kan have forskellige slags mangler, og manglende værdier kan hænge sammen med at tilhøre en bestemt gruppe, eller på anden måde hænge sammen med hvorfor de mangler. I vores superhelte-data kunne man tage et kønsstereotypisk eksempel og forestille sig, at hvis tallenene var selvrapporterede, at flere kvindelige superhelte ikke ville angive vægt. Men manglende værdier kan også hænge sammen med, hvad vi prøver at prædiktere, såsom hvis jeg var en superskurk ville jeg måske “glemme” at opgive alle mine superkræfter til myndighederne.

- Skævheder i annoteringen. En uhensigtsmæssighed kan opstå, hvis en model er trænet på data, der er annoteret manuelt af mennesker med implicitte eller eksplicitte fordomme – nogle kan måske have en fordom mod superhelte klædt helt i sort med flagermusvinger – jeg selv kunne nok blive beskyldt for at favorisere en sådan type.

- Uligevægt i datamængder. Hvis der er en meget mindre mængde data på minoritetsgruppen end på majoritetsgruppen. I vores superheltedata har vi en uligevægt, da vi har langt færre tilfælde af kvindelige superhelte end mandlige, hvilket måske kunne forårsage, at vores model kommer til at virke dårligere på de kvindelige end mandlige superhelte. Kønsfordelingen, efter lidt datarensning (vi har blandet andet restringeret os selv til en binær inddeling af køn), kan ses herunder:

Overstående liste giver et begyndende billede af, hvordan uønskede skævheder kan opstå i data og nedarves til modeller, så lad os nu kort se på teknikker til at forholde os til det.

Våben vi kan forsvare os med

Det kan være en udfordring i sig selv at opdage og stadfæste uønskede skævheder alt efter årsagen til skævheder, og metoderne er forskellige alt efter, om der er tale om den mere klassiske allokeringsproblematik eller repræsentationsproblematikken. Der findes en hær af metrikker til at måle uønskede skævheder på i data eller modeller (se lidt længere nede). Der findes ligeledes en hær af metoder til at forsøge at fjerne eller minimere skævheder i data og modeller alt efter typerne. Overordnet set kan metoder til at prøve at mindske skævheder inddeles i algoritmer, der forsøger

1) at fjerne skævheder i data før selve træningen,

2) at fjerne under træning ved reguleringsteknikker eller

3) at fjerne efter modellen er trænet.

Det kan anbefales at tjekke kampudstyr ud på IBM’s open source tool , hvor flere af de nyeste metoder er implementeret. Et eksempel på et paper, som prøver at stadfæste og fjerne en repræsentativ skævhed i word embeddings er . Et eksempel på gængse metrikker inden for klassifikationsmodeller vil vi gennemgå og diskutere nedenfor, men først skal vi en tur på træningsbane og endelig have os en model på superhelte-datasættet.

På træningsbanen

Superhelte-datasættet er brugt til at træne en binær klassifikationsmodel, som ud fra en række features kan prædiktere, om en superhelt er, ja, en helt eller en skurk, i vores simple verden, god eller ond. Featuresene der er brugt, indbefatter navne, højde, vægt og hvilke superkræfter de har (der er defineret 667 forskellige superkræfter), og som model til dette legeeksempel vil vi blot benytte logistik regression. 33% af datasættet er taget ud til testsæt, hvilket giver 203 eksempler er teste på. På dette testsæt opnås der en accuracy på 0.71, og en makro F1 på 0.61. Til sammenligning er det værd at bemærke, at datasættet er ubalanceret i forhold til god/ond, så hvis vi blot laver et gæt på den mest frekvente klasse, kan vi opnå en baseline accuracy på 0.65, men med 0.39 i F1. Lad os prøve et eksempel af på vores model og opfinde en superhelt. Vi kalder ham “Super Transparent Goble” og giver ham følgende fire superkræfter: Latern Power Ring, Agility, Dimensional Awarness og Speed Force. Derudover giver vi ham lidt substans i form af en højde og en vægt i pund.

En opdigtet superhelt vi kan bede modellen klassificere

Modellen prædikterer, at han er god!

Lad os lege, at vi vil anvende modellen som dørmand på en natklub, og det er kun dem, vi tror, der er skurke, vi vil lukke ind til festen (vi gider jo ikke en alt for kedeligt fest!). Det positive udfald, som superheltene håber på, er da at blive klassificeret som skurk. Men vi ønsker en fair model i forhold til kvindelige og mandlige superhelte, men hvad kan det sige?

Definition af superkræfter…

… eller definition af forskellige fairness-kriterier. har gennemgået, hvordan fairness i maskinlæring kan blive formuleret matematisk, samt forestået sammenligninger af definitionerne med dem i socialvidenskaben på styrker og svagheder. Overordnet inddeler de kriterierne i seks overordnede grupper. For at give et billede af hvor mange definitioner der allerede findes, kan det nævnes, at IBM i deres open source tool AI Fairness 360, har implementeret mere end 70 metrikker. Men metrikkerne er ikke alle kompatible med hinanden – og så er der hele spørgsmålet om, hvorvidt restriktionen af fairness koster en på nøjagtighed for modellen. Nedenfor er der listet nogle forskellige grupper af definitioner (), og enkelte metrikker fremhæves for at åbne diskussionen om fordele og ulemper:

1) Fairness igennem uvidenhed. En model, som ikke betinger på den ‘beskyttede’ attribut, opfylder dette kriterium. I vores superhelte-klassifikationsmodel er køn-variablen taget ud inden træning af modellen, hvilket vinger dette fairness-kriterium af som opfyldt! Desuden kan det bemærkes, at træning med eller uden informationen om kønnet ikke ændrer på performance, i vores tilfælde. Men bemærk nogle ulemper ved dette kriterium; informationen om den beskyttede attribut kan ligge latent i de andre features. F.eks. i vores superhelte-tilfælde kan kønnet ligge latent i de andre variabler, man kunne fx forestille sig at højde, vægt, og selve navnene kunne give et præg om kønnet.

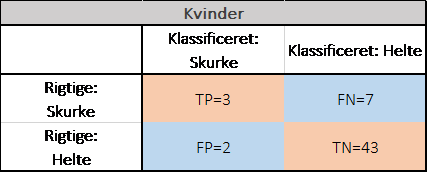

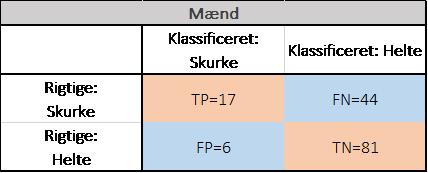

2) Gruppefairness. Herunder hører en af de tidligere anvendte kriterier; ‘Demographic Parity”, som kræver, at en klassifikationsmodel skal prædiktere et bestemt udfald med lige stor sandsynlighed uafhængigt af den beskyttede gruppevariabel. I superhelte-modellen kan vi udregne sandsynligheden for at blive klassificeret som skurk (positiv rate) for hhv. kvinder og mænd ved at se på konfusionmetrikken:

Konfussionmatricer opdelt på kvinder og mænd

For kvinder er sandsynligheden for at blive klassificeret som skurk 9% (5/55), hvorimod der for mænd er 15.5% (23/148) chance for det. Modellen opfylder altså ikke dette kriterium. Her kan man jo så restringere systemet til at opfylde kriteriet, men som blandt andet påpeget i har det nogle åbenlyse ulemper, da det kan føre til scenariet, hvor rigtige skurke i den ene gruppe bliver afvist i døren, og modsat: at rigtige helte i den anden gruppe bliver lukket ind (husk: vi vil kun have skurke med til festen). Dette scenarium kan opstå, hvis der fx er lidt træningsdata i den ene gruppe, eller det faktum at det at tilhøre en bestemt gruppe faktisk er korreleret med udfaldet. Hvis vi kigger på kønsfordelingsplottet, kan vi se, at en mindre procentdel af kvindelige superhelte faktisk er ‘rigtige’ skurke, hvilket kan være en labelbias, men det kan også bare være ’sådan det er’. En fordel ved at bruge dette mål for fairness kan være, hvis man bevidst ønsker at ændre en skævhed i samfundet, fx ved bevidst at optage en vis procentsats fra en bestemt baggrund på en uddannelse, fx kvinder på superheltetræningsakademiet, selvom de er mindre kvalificerede, men så veje op for det ved desuden at lave en række tiltag for at løfte nivauet af ondhed.

3) Equality of opportunity. Denne metrik blev først introduceret i , som et svar til nogle af problemerne med ‘Demographic parity’. Her går kravet på, at den positive klassificering bør være uafhængig af den beskyttede klasse, givet at udfaldet faktisk er ‘positivt’. Så i superhelte-eksemplet kan vi ud fra konfusionmatricerne udregne ‘true positive’-raten. For kvinder bliver det (tp/(tp+fn)) 30% af dem, som rigtigt er skurke, som også bliver klassificeret som sådanne. For mandegruppen er dette tal 29%, hvilket vil sige, at forskellen er lille, og vi i praksis vil kunne sige, at modellen opfylder kriteriet for en fair model, så tillykke! Dette kriterium er mest anvendeligt, når der er størst fokus på at klassificere det positive udfald korrekt, mod at man til gengæld ikke opfatter falske positive som omkostningstunge. Ellers kan man anvende metrikken ‘Equalized odds’, som i tillæg også kræver en lighed i falsk/positiv-raten.

4) Præference-baseret fairness. Kriteriet er introduceret af og prøver at adresse nogle af ulemperne ved overstående metrikker, såsom at de er inkompatible og kan forårsage fald i nøjagtighed at opfylde. Her opstilles i stedet kriteriet, at hver gruppe i princippet har hver sin model, som de skal have præference for, således at skiftet over til den anden gruppes model ikke er gavnligt. Dette giver plads til at forbedre performance inden for hver gruppe.

5) Individuel fairness. En model er fair, hvis den forudsiger det samme udfald for lignede personer/tilfælde.

6) Counterfactual measures. Se fx .

Superhelte-datasættet indeholder også information om race, men der er defineret 61 forskellige racer med alt fra Mutant til Cyborg, og desværre mangler oplysningen for 40% af vores helte, så vi vil undlade at lave analysen, men blot bemærke følgende: Det at sikre en fair model for ‘kvinder’ vs. ‘mænd’ og for ‘Mutanter’ vs. ‘Mennesker’ er ikke det samme som, at vi har sikret, at modellen ikke er diskriminerende mod ‘kvindelige mutanter’.

Der er altid et twist…

… der snyder superhelten ¾ inde i filmen. Nogle af twistene og fælderne ved fair maskinlæring bliver også debatteret i litteraturen, blandt andet i , som viser, hvordan fair maskinlæring, fx ved brug af demographic parity eller equalized odds, kan have en forsinket negativ indflydelse på de grupper, som den prøver at beskytte. Ligeledes ser fra dette års FAT* konference (Fairness, Accountability, and Transparency) på, hvordan langtidseffekterne kan modelleres ved hjælp af simulationer. Derudover kan nævnes, som har fokus på de “fælder”, som eksisterer rundt om fair maskinlæring. Et eksempel er, hvis modellen bliver fulgt på en skæv måde. Det kunne tænkes, i vores superhelte-eksempel, at dørmanden ikke følger modellens anbefalinger nær så ofte for det ene køn som for det andet. Til sidst kan nævnes, som sætter spørgsmålstegn ved, om fokus kun bør være på såkaldte beskyttede attributter, eller om folks opfattelse af, hvad der er fair, ikke i lige så høj grad går på, hvilke informationer modellen bruger i forskellige sammenhænge. F.eks. kunne det måske opfattes som unfair, at vores superhelte-model faktisk benytter information om vægt for at afgøre, om jeg er en skurk, der må komme ind til en festen eller ej.

To be continued…

Som i de fleste superhelte-film, lægger det op til en 2’er, for selvom fokus på fair maskinlæring har været voldsomt stigende de seneste år, er feltet langt fra i mål, og som diskuteret er mange af spørgsmålene nogle, der ikke kun skal løses teknisk – men i høj grad også etisk.

Referencer

Bolukbasi, T., Chang, K. W., Zou, J. Y., Saligrama, V., & Kalai, A. T. (2016). Man is to computer programmer as woman is to homemaker? debiasing word embeddings. In Advances in neural information processing systems (pp. 4349-4357).

D’Amour, A., Srinivasan, H., Atwood, J., Baljekar, P., Sculley, D., & Halpern, Y. (2020, January). Fairness is not static: deeper understanding of long term fairness via simulation studies. In Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency (pp. 525-534).

Gajane, P., & Pechenizkiy, M. (2017). On formalizing fairness in prediction with machine learning. arXiv preprint arXiv:1710.03184.

GrgiÄ?-HlaÄa, N., Zafar, M. B., Gummadi, K. P., & Weller, A. (2018, April). Beyond distributive fairness in algorithmic decision making: Feature selection for procedurally fair learning. In Thirty-Second AAAI Conference on Artificial Intelligence.

Hardt, M., Price, E., & Srebro, N. (2016). Equality of opportunity in supervised learning. In Advances in neural information processing systems (pp. 3315-3323).

Kusner, M. J., Loftus, J., Russell, C., & Silva, R. (2017). Counterfactual fairness. In Advances in Neural Information Processing Systems (pp. 4066-4076).

Liu, L. T., Dean, S., Rolf, E., Simchowitz, M., & Hardt, M. (2018). Delayed impact of fair machine learning. arXiv preprint arXiv:1803.04383.

Selbst, A. D., Boyd, D., Friedler, S. A., Venkatasubramanian, S., & Vertesi, J. (2019, January). Fairness and abstraction in sociotechnical systems. In Proceedings of the Conference on Fairness, Accountability, and Transparency (pp. 59-68).

Zafar, M. B., Valera, I., Rodriguez, M., Gummadi, K., & Weller, A. (2017). From parity to preference-based notions of fairness in classification. In Advances in Neural Information Processing Systems (pp. 229-239).

Kontakt:

Communications Specialist Lisa Lorentzen tlf.: +45 93 52 17 64 email: lisa.lorentzen@alexandra.dk

Læs hele pressemeddelelsen på Via Ritzau her: https://via.ritzau.dk/pressemeddelelse/hvordan-bliver-computeren-en-retfaerdig-superhelt-aka-lidt-om-fairness-i-maskinlaering?releaseId=13593237

** Ovenstående pressemeddelelse er videreformidlet af Ritzau på vegne af tredjepart. Ritzau er derfor ikke ansvarlig for indholdet **